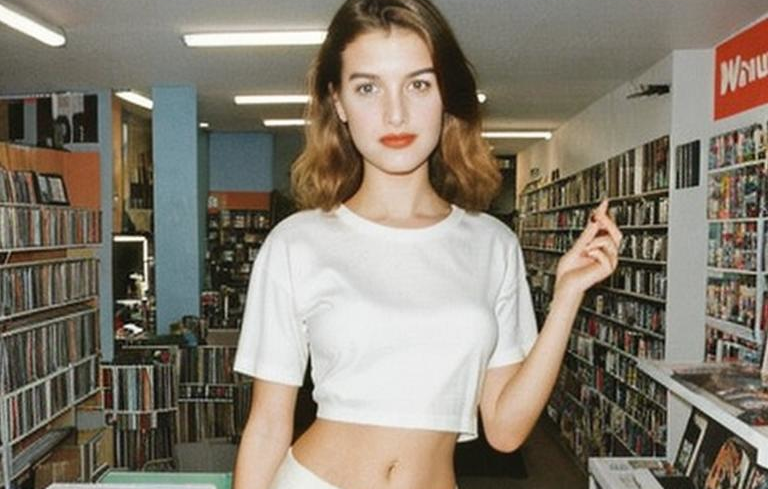

Для ностальгирующих по эстетике 90х.

После пары недель экспериментов с kohya_ss и подробом параметров зарелизил вторую версию LoRa для создания картинок в стиле фотографий на мыльницы со вспышкой.

Скачать для экспериментов можно на Civitai.

По сравнению с первой версией эту лору можно использовать с большей strength не ломая изображение.

В последний заход потратил часов восемь на тренировку и около 80 эпох. По факту оказалось, что после 5-6 эпох LoRa уже сильно перетренирована, хотя Loss так и не достиг минимума и продолжал уменьшаться.

По сравнению с первой версией эту лору можно использовать с большей strength не ломая изображение.

В последний заход потратил часов восемь на тренировку и около 80 эпох. По факту оказалось, что после 5-6 эпох LoRa уже сильно перетренирована, хотя Loss так и не достиг минимума и продолжал уменьшаться.

Насколько понимаю причин переобучения может быть две: недостаточно большой датасет и большой размер сети для данного датасета. Как вариант решения проблемы переобучения можно использовать dropout для отключения нейронов во время тренировки, но почему-то ни в одном туториале не видел чтобы кто-то использовал эту технику. Второй вариант - попробовать уменьшить network dim, 128 в моем случае возможно слишком большое значение.