Добро пожаловать в мой псевдо-анонимный блог. Присутствуют выбросы бессознательного материала и субъективное мнение.

На кофе ☕ https://pay.cloudtips.ru/p/a368e9f8

Добро пожаловать в мой псевдо-анонимный блог. Присутствуют выбросы бессознательного материала и субъективное мнение.

На кофе ☕ https://pay.cloudtips.ru/p/a368e9f8

В заметке расскажу как на python сделать простого чат бота для телеграм на базе последней версии llm модели llama-3. Предположим у нас уже установлен python и CUDA (если хотите использовать gpu для ускорения). Для взаимодействия с моделью на python есть несколько вариантов, чтобы не усложнять будем использовать библиотеку llama.cpp и квантованную модель в формате GGUF. Обратите внимание, нужна Instruct версия. Подготовка В телеграм с помощью @BotFather создайте нового бота и получите токен....

Только обнаружил, что уже год Forgejo поддерживает экшены на подобии Github Actions для автоматического запуска ci/cd пайплайнов. Пайплайны по синтаксису совместимы с Github и поддерживают готовые Github экшены https://github.com/marketplace?type=actions. У меня изначально ci/cd был реализован на Forgejo + Drone, потом Drone был заменен на Woodpecker (форк Drone), ну а затем собственно увидел, что появился встроенный механизм и перешел на него. Для работы экшен модуль должен быть включен в конфиге Forgejo:...

В заметке опишу как организовать доступ к серверу в локальной сети через Xray. Про базовую настройку Xray можно посмотреть тут. В терминологии xray схема с реверс-прокси состоит из двух участников: portal и bridge. Portal - это сервер который доступен из интернет и который выполняет роль реверс-прокси. Bridge - сервер/клиент который находится в приватной сети и через который осуществляется доступ к ресурсу в приватной сети. Допустим у нас в локальной сети есть веб-сервер без публичного IP и мы хотим опубликовать его через xray portal....

Написал небольшой скрипт для разграбления Youtube канала iXBT.Games и отправки аудио в телеграм. Если следишь за творчеством ребят и хочешь слушать видео и стримы в виде подкастов в телеге - подключайся https://t.me/ixbt_audio. Наверное нет смысла заводить репу на github для одного скрипта, выложу тут как есть, может кому-то пригодится. В каталоге со скриптом необходимо создать каталог cache/, thumb.jpg - изображение 320x320 для обложки к аудио и .env файл с переменными:...

Для ностальгирующих по эстетике 90х. После пары недель экспериментов с kohya_ss и подробом параметров зарелизил вторую версию LoRa для создания картинок в стиле фотографий на мыльницы со вспышкой. Скачать для экспериментов можно на Civitai. По сравнению с первой версией эту лору можно использовать с большей strength не ломая изображение. В последний заход потратил часов восемь на тренировку и около 80 эпох. По факту оказалось, что после 5-6 эпох LoRa уже сильно перетренирована, хотя Loss так и не достиг минимума и продолжал уменьшаться....

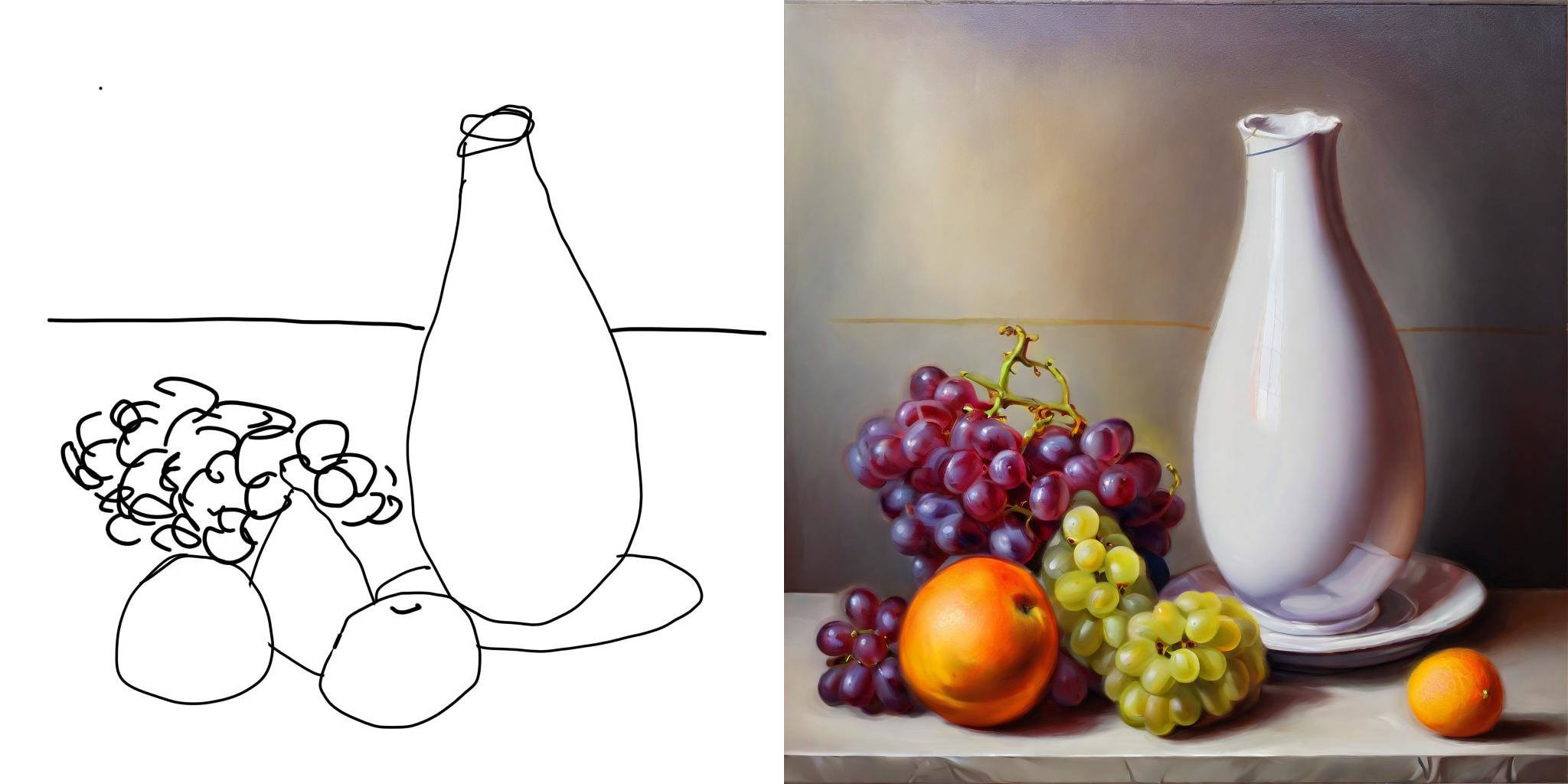

Добавил новую функцию для telegram-бота @pixelmuse_bot. Теперь на вход ему можно отправить кривой рисунок с командой в описании /imagine2 текст запроса и на выходе получить что-то осмысленное и даже красивое. Как это работает под капотом. Никакой магии, для управления нейросетью используем controlnet. Controlnet заставляет нейросеть использовать информацию о границах объектов как опору для создания нового изображения. После получения изображения от пользователя обрабатываем его с помощью cv2.Canny для определения краев. Тут пришлось поэксперементировать с параметрами чтобы края определялись в том числе на фотографиях, где переходы, например на лице, могут быть плавными, а потеря этих границ даёт модели слишком много свободы для творчества....

В общем, кому не хватало Midjourney у нас дома - добро пожаловать в @pixelmuse_bot. Что бот умеет на данный момент: Создавать картинки по текстовому запросу Используется автоматический машинный перевод текста на английский, поэтому запрос может быть практически на любом языке Можно выбрать из 5 моделей: реализм, аниме, киборги, sci-fi окружение, стикеры (по факту под капотом две модели + разные LoRa) Можно загрузить свою фотографию для обработки img2img Можно сделать апскейл результата x1....